2022年6月13日掲載

白楽の意図:人口知能(AI)で合成画像(動画も)を簡単に作れるディープフェイク(deepfake)。従来のフォトショップでの加工とは次元が異なる。今後、論文画像のねつ造・改ざんを防ぐ・見破るにはどうするか? ロンシャン・ユー(Rongshan Yu)の「2022年5月のPatterns」論文を解説した「2022年5月のMind Matters」論文を読んだので、紹介しよう。

ーーーーーーー

目次(クリックすると内部リンク先に飛びます)

1.日本語の予備解説

2.ロンシャン・ユーの「2022年5月のPatterns」論文

3.「2022年5月のMind Matters」論文

4.クレーマーの「2022年5月のChemistry World」論文

9.白楽の感想

10.コメント

ーーーーーーー

【注意】

学術論文ではなくウェブ記事なども、本ブログでは統一的な名称にするために、「論文」と書いている。

「論文」ポイントのみの紹介で、白楽の色に染め直し、さらに、理解しやすいように白楽が写真・解説など加え、色々加工している。

研究者レベルの人で、元情報を引用するなら、自分で元情報を読んでください。

●1.【日本語の予備解説】

★7-73 画像のAI合成:ウェスタンブロット | 白楽の研究者倫理

2021年7月3日掲載

白楽の意図:「ねつ造・改ざん」で一番多いのがウエスタンブロット画像の加工だが、通常、「既存の画像」を加工する。ところが、敵対的生成ネットワーク(Generative Adversarial Nets:GAN)を使えば、「既存の画像」は不要で、ウエスタンブロット画像を含め、全く新しい画像を人工的に合成できる。となると、GANで合成した画像を「ねつ造・改ざん」と見破るのは至難になる。GANで画像を合成する原理はチンプンカンプンだが、ペン・ルオ(Peng Luo)の「2021年1月のbioRxiv」論文を読んだ(読めていない!)ので、紹介しよう。

★20xx年x月xx日:著者名不記載(クリスタルメソッド株式会社):ディープフェイクとは?実例を含めてわかりやすく解説!

ディープフェイクとは、ディープラーニング(AIの深層学習)とフェイク(偽物)を組み合わせた造語です。

映画やゲームなどで使われていた技術ですが、最近ではディープフェイク動画を作成できるアプリが登場するなど一般の方にも広く認知されるようになりました。

― 中略 ー

Photoshopなどの画像編集ソフトを使用し、画像の顔を差し替えたり合成したりすることは過去にもありましたが、近年ではディープフェイクを用いて顔を差し替えるだけでなく、発する言葉に合わせて口を動かしたり表情を変えたりと、まるで本人が話しているのと区別がつかないレベルにまで技術が急成長してきました。最近ではマスクを付けた人の顔をディープフェイクにより検出するような研究も進んでいます。

続きは、原典をお読みください。

★2022年4月25日:著者名不記載(AIsmiley):今話題のディープフェイクとは?進化したAI技術で本物そっくりの顔を生成

ディープフェイクとは、ディープラーニング技術を活用して作成された合成メディアです。その人が実際に行っていない動作をしたり、実際口に出していないことを発言したりしているかのように描くことができます。

ディープフェイクの技術は年々?度化しており、もはや?間が眼で見て判別することは困難なレベルの高い画質の画像が?成できるようになりつつあります。

―――

GANは、学習したデータの特徴をもとに、実在していないデータの生成を行ったり、データの変換を行ったりすることができます。

その派生として注目を集めているStyleGANは、「写真を証拠にできる時代は終わった」と言われてしまうほど、極めて高精度な画像の生成を行えるようになったのです。実際にStyleGANによって生み出された画像を見てみても、一目で「実在しない人物」だと判断することは不可能なほど高精度な画像であることが分かります。

続きは、原典をお読みください。

★ たくさん記事がある

ディープフェイクに関する日本語記事はたくさんある。

例えば「gigazine.net ディープフェイク」で検索すると、「gigazine」の記事がズラズラとでてくる → gigazine.net ディープフェイク – Google 検索、(保存版)

●2.【ロンシャン・ユーの「2022年5月のPatterns」論文】

★書誌情報と著者情報

- 論文名:Deepfakes: A new threat to image fabrication in scientific publications?

日本語訳:ディープフェイク:科学出版物の画像ねつ造への新たな脅威? - 連絡著者:Rongshan Yu

著者の紹介:ロンシャン・ユー(Rongshan Yu、俞容山、写真出典)は、1999年(?)にシンガポール・ナショナル大学(National University of Singapore)で研究博士号(PhD)を取得した。

著者の紹介:ロンシャン・ユー(Rongshan Yu、俞容山、写真出典)は、1999年(?)にシンガポール・ナショナル大学(National University of Singapore)で研究博士号(PhD)を取得した。

論文出版時の所属・地位は、中国の厦門大学(あもいだいがく)・教授(Min Jiang Professor, Department of Computer Science, School of Informatics, Xiamen University,China)。出典:Home | personal- 掲載誌・巻・ページ:Patterns (2022)

- 発行年月日:2022年5月13日

- 指定引用方法:

- DOI: https://doi.org/10.1016/j.patter.2022.100509

- ウェブ:https://www.cell.com/patterns/fulltext/S2666-3899(22)00101-5?_returnURL=https%3A%2F%2Flinkinghub.elsevier.com%2Fretrieve%2Fpii%2FS2666389922001015%3Fshowall%3Dtrue

- PDF:https://www.cell.com/action/showPdf?pii=S2666-3899%2822%2900101-5

- 著作権:Creative Commons Attribution – NonCommercial – NoDerivs (CC BY-NC-ND 4.0):作品を複製、頒布、展示、実演を行うにあたり、著作権者の表示を要求し、非営利目的での利用に限定する(クリエイティブ・コモンズ – Wikipedia)

●【論文内容】

本論文の内容は、次の「3.【「2022年5月のMind Matters」論文】」で紹介しているので、省略する。

実は、白楽は、先に「3.【「2022年5月のMind Matters」論文】」を読んでしまった。そして、ロンシャン・ユーの「2022年5月のPatterns」論文が重要なオリジナル論文だと気がついたわけだ。

●3.【「2022年5月のMind Matters」論文】

★書誌情報と著者情報

- 論文名:The Threat That Deepfakes Pose to Science Journals

日本語訳:ディープフェイクが科学誌にもたらす脅威 - 著者:NEWS

- 著者の紹介:なし

- 掲載誌・巻・ページ:Mind Matters

- 発行年月日:2022年5月27日

- 指定引用方法:

- DOI:

- ウェブ:https://mindmatters.ai/2022/05/the-threat-that-deepfakes-pose-to-science-journals/

- 保存版:https://web.archive.org/web/20220527200340/https://mindmatters.ai/2022/05/the-threat-that-deepfakes-pose-to-science-journals/

●【論文内容】

本論文は学術論文ではなくウェブ記事である。本ブログでは統一的な名称にするため論文と書いた。

方法論の記述はなく、いきなり、本文から入る。

ーーー論文の本文は以下から開始

★偽造画像

中国の厦門大学(あもいだいがく)の研究チームが、研究データである画像をディープフェイクで作成してみたら、簡単に作成でき、かつ偽造画像だと見破るのが困難だった、と報じた。

つまり、

実際には研究しないで、ディープフェイクで画像をねつ造し、研究論文に発表できる。 → BOB YIRKA, “COMPUTER SCIENTISTS SUGGEST RESEARCH INTEGRITY COULD BE AT RISK DUE TO AI GENERATED IMAGERY” AT TECH EXPLORE (MAY 25, 2022)

厦門大学(あもいだいがく)の研究を紹介しよう。

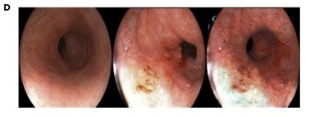

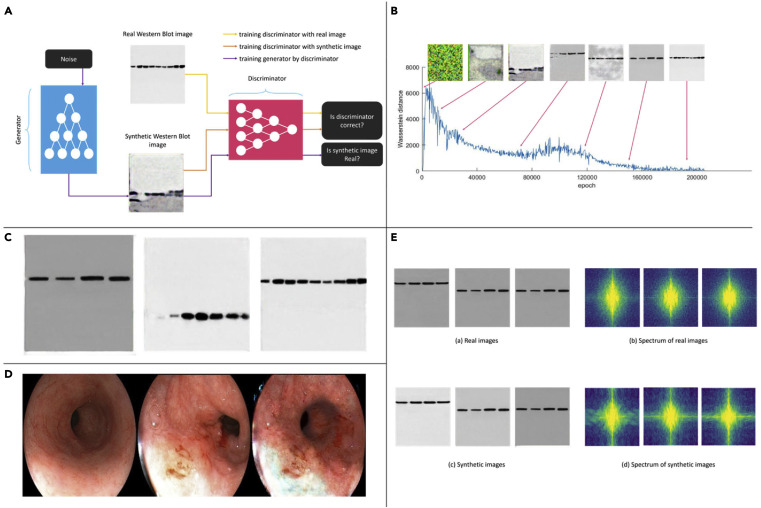

従来、敵対的生成ネットワーク(Generative Adversarial Nets:GAN)で、驚くほどリアルな人間の顔の画像を作れることがわかっていた。厦門大学(あもいだいがく)の研究チームは、その技術を使って偽の研究画像を、簡単に作ることに成功した。彼らは2セットの研究データ画像を作った。セットの1つ目はタンパク質の検出に使うウエスタンブロット画像で、セットの 2つ目は食道がんの画像だった。 → BOB YIRKA, “COMPUTER SCIENTISTS SUGGEST RESEARCH INTEGRITY COULD BE AT RISK DUE TO AI GENERATED IMAGERY” AT TECH EXPLORE (MAY 25, 2022)

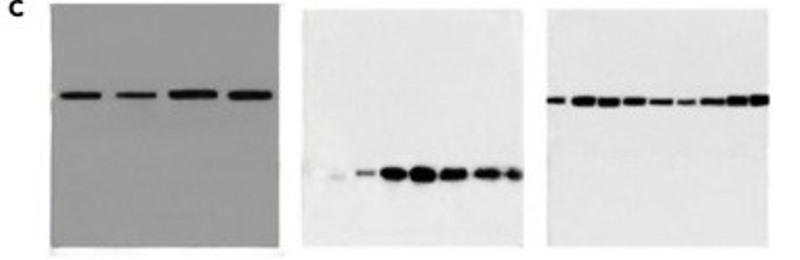

彼らのディープフェイク作業過程(A)(B)と作成した画像は次のとおりだ。2セットの画像は(C)と(D)で、(E)は分析である。。

出典:Patterns (2022). DOI: 10.1016/j.patter.2022.100509

出典:Patterns (2022). DOI: 10.1016/j.patter.2022.100509

論文では真偽が判定できるかの試験もした。

ディープフェイクの検出がどれくらい難しいか、この分野の専門家にテストしてもらった。

3人の生物医学専門家にウエスタンブロット画像の区別を依頼した。

2人はそれぞれ10%と30%の精度だった。10%と30%という精度は、真偽を識別できなかったということだ。

3番目の専門家は、実際のウエスタンブロット画像と偽のウエスタンブロット画像では、画像と背景の境界が微妙に異なるという特徴で識別し、60%の精度で識別した。60%の精度は少しマシだが、実用とは程遠い。

結論を言えば、人口知能で作った偽の画像と実際の画像とを肉眼で区別するのは非常に難しいという結果だ。3番目の専門家に少し特徴をつかまれたが、この特徴は、方法を改善することでなくすことができる。 → LIANSHENG WANG, LIANYU ZHOU, WENXIAN YANG, RONGSHAN YU, DEEPFAKES: A NEW THREAT TO IMAGE FABRICATION IN SCIENTIFIC PUBLICATIONS?, PATTERNS, VOLUME 3, ISSUE 5, 2022, 100509, ISSN 2666-3899, HTTPS://DOI.ORG/10.1016/J.PATTER.2022.100509.

以下に、(C)合成されたウエスタンブロット画像、(D)合成された食道がん画像を大きくした。あなたは、合成画像だと見破れます?

見破った超能力者のアナタ、どこで見破りました?

★対処方法

今のところ、明確な対処法はない。

ディープフェイク検出法が進歩すれば、ディープフェイク作成法が進歩する、という「イタチごっこ」になる。

有望な対処法は、専門家団体が、最先端のディープフェイク検出方法ですべての画像をスキャンすることだ。これを組織的・継続的に行なう。

「イタチごっこ」なので、ディープフェイク対処法が進歩すれば、作成法も進歩するというリスクはある。

従って、作成法が進歩したら、さらに進歩したディープフェイク検出装置を使って、ランダムに組織的・定期的に検出する。

過去に見つからなかったとしても、その後、不正画像が見つかれば、研究者としてのキャリアを破滅するシステムも構築する。つまり、ディープフェイクは、ウソの資格を履歴書に書いたようなものなので、履歴書のウソがバレれば、数年後でも研究者を解雇する現システムを踏襲する。

ディープフェイクすれば、将来のキャリア破滅のリスクに直面するとシステムが構築できれば、ディープフェイク画像で論文発表すると、昔にさかのぼって摘発されので、ディープフェイク画像で論文発表しない。摘発率100%のこのシステムを構築し、発覚したら厳罰処分をすれば、有力な対処法になる。

この対処法が成功するかどうかは、学術誌がいかに真剣に不適切な画像操作の対処に取り組むかによる。

「2009年のNature」論文は、学術誌はさまざまなタイプの不適切な画像操作(必ずしもディープフェイクではない)を取り締まっていると述べた。 → Science journals crack down on image manipulation | Nature

しかし、それから7年後の2016年、エリザベス・ビック(Elisabeth Bik)らは、学術誌に膨大な数の不適切な画像操作があると指摘した。つまり、「2009年のNature」論文 の7年後、全く取り締まれてなかった。 → The Prevalence of Inappropriate Image Duplication in Biomedical Research Publications

2019年、「Enago Academy」は次のように問題を指摘した。

エリザベス・ビックは、不適切画像を5つのカテゴリに分類した。①単純な複製、②再配置の複製、③画像改変して複製、④部分的な切除、⑤美化する加工。

④部分的な切除、⑤美化する加工(色覚異常の読者のために行なうこともある)は、必ずしも研究不正ではない。

①②③の画像複製は問題がある。行為が偶発的であろうが、間違いであろうが、意図的だろうが、欠陥画像データなので、画像は無効で、論文は撤回されなければならない。

学術界は、学術誌の編集者と査読者が、論文出版前にネカトを含めたデータの異常を指摘する重要な役割を果たすことを長年認めてきた。

それでも、不正画像事件は多発している。つまり、編集者や査読者が、不適切な画像を見破ることは非常に難しい。それで、論文出版後に、論文読者が多くのねつ造・改ざん画像を指摘してきた。

しかし、パブピア(PubPeer)のコメントに、「痕跡を残さずに…ごまかすのはとても簡単です…」と投稿されている。 → ENAGO ACADEMY, “SCIENTIFIC FRAUD: HOW JOURNALS DETECT IMAGE MANIPULATION (PART 1)” AT ENAGO (JULY 20, 2019)

2020年、大手の学術出版社であるエルゼビア社(Elsevier)は、 「論文の不適切画像は依然として深刻な問題である」と認めている。 → 2020年4月29日記事:Five things every researcher should know about image manipulation

そして、ディープフェイクは学術誌の不正画像対策のハードルを大幅に引き上げた。

以下の動画はディープフェイクのビデオ。

★音声も偽造

ディープフェイクは人の声も偽造できる(ディープヴォイス“deep voice” technology)。

あなたの声をデジタル技術で偽造し、あなたの銀行員をダマすこともできる。 → 2022年2月22日記事:Deepfakes Can Replicate Human Voices Now — Maybe Yours | Mind Matters

ディープヴォイスで、既に、大規模な銀行詐欺が実行された。

2020年初頭、香港の銀行のマネージャーは、男性からの電話を受け、彼が以前から信頼している会社の取締役の声だと認識した。取締役は朗報を伝え、彼の銀行に3,500万ドル(約35億円)の送金を依頼した。適正な手続きの後、彼は、すべてが合法であると信じて、送金した。 → 2021年10月14日記事:Fraudsters Cloned Company Director’s Voice In $35 Million Bank Heist, Police Find

ディープフェイクの世界では、作成する技術がより高度になる一方で、不正を検出する技術が追い付けていない。

●4.【クレーマーの「2022年5月のChemistry World」論文】

★書誌情報と著者情報

- 論文名:AI-generated images could make it almost impossible to detect fake papers

日本語訳:人口知能で作った画像は、ねつ造論文の検出をほぼ不可能にする - 著者:Katrina Krämer

著者の紹介:カトリーナ・クレーマー(Katrina Krämer、写真出典は本論文)は、2014年9月)に英国のクイーン・メアリー (ロンドン大学)(Queen Mary, University of London)で化学の研究博士号(PhD)を取得した。

著者の紹介:カトリーナ・クレーマー(Katrina Krämer、写真出典は本論文)は、2014年9月)に英国のクイーン・メアリー (ロンドン大学)(Queen Mary, University of London)で化学の研究博士号(PhD)を取得した。

論文出版時の所属・地位は、中国の英国王立化学会・「Chemistry World」記者(Royal Society of Chemistry、Chemistry World science correspondent)。出典:(3) Katrina Krämer | LinkedIn- 掲載誌・巻・ページ:Chemistry World

- 発行年月日:2022年5月24日

- 指定引用方法:

- DOI:

- ウェブ:https://www.chemistryworld.com/news/ai-generated-images-could-make-it-almost-impossible-to-detect-fake-papers/4015708.article

- 保存版:https://archive.ph/LAcZ8

●【論文内容】

本論文は学術論文ではなくウェブ記事である。本ブログでは統一的な名称にするため論文と書いた。

本論文の内容は、前の「3.【「2022年5月のMind Matters」論文】」の内容と基本的には同じである。異なる部分のエリザベス・ビックの登場部分だけ抽出し、他は省略した。

★エリザベス・ビック

画像分析では世界一のネカトハンた―であるエリザベス・ビック(Elisabeth Bik)に意見を求めた。

「私はこのタイプの技術について非常に心配してきました。このディープフェイク技術を悪用した画像は、すでに論文中の画像として出版されていると思います」。

ビックは、彼女が発見した600報以上のネカト論文のねつ造画像は、おそらく同じ論文工場が作った画像で、人口知能(AI)で作られたと考えているそうだ。

●9.【白楽の感想】

《1》ディープフェイクの脅威

ディープフェイクの現実の脅威は学術界以外で大きい。

例えば、

- アダルトビデオのポルノ俳優に有名人や知人の女性の顔を置き換える。

- 政治家(例:ゼレンスキー大統領)の演説で、こちらが望む話しを彼が発言したようにさせる。

偽造と本物の区別がつかない。

娯楽映画では大活躍である。

事実を伝えるハズの報道ニュースでは、ディープフェイクの脅威に、どう対処する(できる)のだろうか?

真実を伝えるハズの学術論文では、データねつ造をどう防げる(見破れる)のだろうか?

「真」実を「写」していないので、「写真」という言葉が成り立たない。

「百聞は一見にしかず」も成り立たない。

スゴイ世界になってきました。

老爺心で書くが、「アダルトビデオの顔すり替え」は逮捕されるからね。 → 2020年10月2日:「ディープフェイク職人」逮捕 AVの顔すり替えた容疑:朝日新聞デジタル

《2》追記:ディープフェイクの例

2022年6月14日、追加。

Deepfake data 😱 pic.twitter.com/P3BWUUOQUf

— A. Stolfi (@StolfiAlberto) June 12, 2022

ーーーーーー

日本がスポーツ、観光、娯楽を過度に追及する現状は日本の衰退を早め、ギリシャ化を促進する。日本は、40年後に現人口の22%が減少し、今後、飛躍的な経済の発展はない。科学技術と教育を基幹にした堅実・健全で成熟した人間社会をめざすべきだ。科学技術と教育の基本は信頼である。信頼の条件は公正・誠実(integrity)である。人はズルをする。人は過ちを犯す。人は間違える。その前提で、公正・誠実(integrity)を高め維持すべきだ。

ーーーーーー

ブログランキング参加しています。

1日1回、押してネ。↓

![]()

ーーーーーー

★記事中の画像は、出典を記載していない場合も白楽の作品ではありません。

●10.【コメント】

注意:お名前は記載されたまま表示されます。誹謗中傷的なコメントは削除します